ADsP

ADsP 3과목 5-4 인공신경망 분석 | 정리📝

studyrooom

2024. 9. 30. 16:57

SMALL

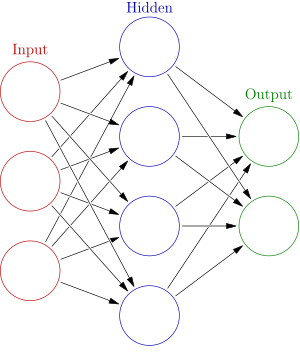

인공신경망: 뉴럴 네트워크(뇌 신경시스템)에서 영감을 받아 만들어진 모형

- 분류 및 회귀 문제에 사용 가능

비지도 학습에도 사용 가능 - 단순한 계산 unit을 매우 많이 생성하고 이를 상호 결합하게끔 만든 시스템

이러한 시스템은 복잡한 현상을 재현할 수 있음 - 데이터 내 비선형적인 관계를 포착하고 이를 통해 목표 변수를 예측

- 일반적으로 다층 퍼셉트론을 의미함

정보의 흐름: 입력층 → 은닉층 → 출력층 - 역전파 알고리즘(Back Propagation): 연결강도를 갱신하기 위해 예측된 결과와 실제값의 차이인 에러의 역전파를 통해 가중치를 조정 (목적함수를 최적화 하기 위해 사용함)

인공신경망에서 동일 입력층에 대해 원하는 값이 출력되도록 개개의 가중치(weight)를 조정하는 방법 - neuralet( ) 함수 사용 시 일반화 가중치(generalized weight)는 로지스틱 회귀모형에서의 회귀계수와 동일하게 해석됨

- 유용한 상황

- 입력-출력 간 수학적 공식이 분명하지 않을 때

- 설명보다는 예측 자체가 중요할 때

- 학습 데이터가 아주 많을 때

인공신경망 분석의 장단점

장점

- 잡음에 민감하지 않음

- 비선형적 문제를 분석하는 데 유용

- 패턴인식, 분류, 예측 등 문제에 효과적

- 스스로 가중치를 학습함

단점

- 모형이 복잡할 경우 오래 걸림

- 초기 가중치에 따라 전역해가 아닌 지역해로 수렴할 수 있음

- 추정한 가중치의 신뢰도 낮음

- 결과에 대한 해석이 어려움

- 은닉층의 수와 은닉 노드의 수를 정하기 어려움

인공신경망 예시

- 입력 뉴런: 입력 변수의 값 혹은 정형화된 값을 가지고 있음

- 히든(은닉) 뉴런: 내부 연산이 발생하는 뉴런 / 비선현성을 더함

- 출력 뉴런: 예측값을 계산하는 뉴런

- RNN, CNN, GAN

활성화 함수

입력 신호의 총합을 출력 신호로 변환하는 함수

입력변수의 속성에 따라 활성화 함수 선택 X

다음 층으로 어떻게 출력할지 결정함

각 뉴런에서 연산된 값은 활성화 함수(activation function)를 통과함 (히든유닛 or 출력유닛)

활성화 함수는 학습 대상이 아님 (파라미터 없음)

- 계단(step) 함수

- 시그모이드 함수 Logistic Function (=sigmoid function)

$g(x)=\frac{1}{1+exp(-x)}$

- 0~1 사이의 값 출력

- 이진 분류 출력유닛에 주로 사용

- 단층신경망에서 활성화 함수로 사용하면 로지스틱 회귀모형과 작동원리가 유사함

*단층신경망: 입력층이 직접 출력층에 연결됨 - 회귀계수가 음수면 역 S자 그래프가 나타남

- Hyperbolic Tangent Function (Tanh)

$g(x)=\frac{exp(x)-exp(-x)}{exp(x)+exp(-x)}$

- -1~1 사이의 값 출력

- 이진 분류 출력유닛에 주로 사용

- Softmax Function

- 다지 분류에 사용

- ReLU $=max(x,0)$

- 딥러닝 모형에 많이 사용함

- 딥러닝 모형에 많이 사용함

단일 뉴런의 학습 (단층 퍼셉트론)

초평면(Hyperplane)

인공신경망 학습 유의 사항

- 입력 변수

특정 변수의 스케일이 지나치게 크거나 작을 때 모형 학습에 크게 영향을 줄 수 있어 데이터 전처리 과정이 필요함 - 가중치 초깃값

인공신경망 학습에 사용되는 역전파 알고리즘은 모형의 파라미터 초깃값 영향을 많이 받음

랜덤하게 초기화(initialize)하는 알고리즘 별도로 적용 - 은닉층 수

은닉층 수가 많을수록 모형의 복잡도가 올라감 → 과적합 발생 → 네트워크의 일반화 어려움

너무 적으면 네트워크가 복잡한 의사결정 경계 생성이 어려움

은닉층의 뉴런의 개수와 은닉층의 개수는 직접 설정해야 하므로 사람의 직관, 경험에 의존함 (자동X) - 학습률(learning rate)

모형이 해(solution)에 도달하는 속도 및 정교함을 컨트롤하는 매개변수 (적절히 큰 값에서 decay) - 과대 적합 방지

- 조기 종료(early stop): 모형의 검증 오차가 더 이상 감소하지 않으면 학습 중단

- 패널티 부여: 가중치가 지나치게 커지는 것을 막기 위한 패널티 부여

딥러닝

- 인공신경망 구조에서 은닉층(hidden layer)을 복수로 설정하여 모형의 복잡도를 더한 구조

- 피드 포워드 신경망: 정보가 전방으로 전달되는 것으로 생물학적 신경계에서 나타나는 형태로 딥러닝의 핵심 구조 개념임

- 딥러닝 소프트웨어

- TensorFlow

- Caffe

- Theano

- Mxnet

- Keras

- PyTorch

반응형

LIST